1. Preuzmi GPT4All model sa zvaničnog izvora:

Modeli za GPT4All se nalaze na https://www.nomic.ai/gpt4all

Odaberi odgovarajuću instalaciju za preuzimanje tj. MacOS, Linux, Windows.

Preuzeo sam instalaciju za linux ubuntu gpt4all-installer-linux.run

✅ 1. Otvori terminal i pređi u direktorijum gde je fajl

Na primer, ako je u folderu Downloads, ukucaj:

cd ~/Downloads(proveri komandomlsda vidiš da li je tu fajlgpt4all-installer-linux.run)

✅ 2. Napravi fajl izvršnim (dodaj execute prava)

chmod +x gpt4all-installer-linux.runOva komanda omogućava da se .run fajl može pokrenuti kao program.

✅ 3. Pokreni instalaciju

./gpt4all-installer-linux.run

✅ 4. Prati grafički instalacioni proces

Nakon ovoga trebalo bi da se pokrene GUI (grafički prozor za instalaciju GPT4All) — prati uputstva i odaberi lokaciju instalacije.

Ponuđeni su sledeći modeli:

Rasoner v1

LIama 3 8B Instruct

DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-LIama-8B

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-1.5B

LIama 3.2 3B Instruct koji model mi je najbolji za mašinu sa 16Gb rama i moju potrebu za komunikaciju na srpskom jeziku i programiranje u python3?

LIama 3.2 1B Instruct

NOus Hermes 2 Mistral DPO

Mistral Instruct

LIama 3.1 8B Instruct 128k

Mistral OpenOrca

GPT4All Falcon

Orca 2 (Medium)

Ghost 7B v0.9.1

MPT Chat

Phi-3 Mini Instruct

Mini Orca (Small)

EM German Mistral

Qwen2-1.5B-Instruct

Za moju mašinu sa 16 GB RAM-a, i moje potrebe za komunikacijom na srpskom jeziku i programiranjem u Pythonu, najoptimalniji izbor biće manji modeli koji mogu efikasno koristiti memoriju i pružiti solidne performanse u obema domenima. Evo kako bih analizirao opcije:

Najbolji modeli za mašinu sa 16Gb RAM-a:

LIama 3.2 3B Instruct:- RAM zahtev: Oko 6-8 GB (u zavisnosti od implementacije).

- Podrška za jezik: Dobro razume srpski, ima dobru fleksibilnost za različite zadatke, uključujući programiranje u Pythonu.

- Podrška za Python: Sposoban za generisanje Python koda i objašnjenje koncepta.

- Zašto je dobar: Dobar balans između memorijskih zahteva i sposobnosti za jezičke zadatke.

Mistral Instruct:- RAM zahtev: Oko 6-7 GB.

- Podrška za jezik: Mistral modeli su poznati po dobrom razumevanju jezika, uključujući srpski.

- Podrška za Python: Sposoban za generisanje Python koda, bolji u tehničkim zadacima.

- Zašto je dobar: Mistral je efikasan i brz za kodiranje i rešavanje tehničkih problema.

LIama 3.1 8B Instruct 128k:- RAM zahtev: Možda se približava gornjoj granici za tvoju mašinu, oko 8-10 GB.

- Podrška za jezik: Odlična podrška za srpski, ali preopterećenje memorije može uticati na performanse.

- Podrška za Python: Izuzetno dobar za programiranje u Pythonu, jer je dizajniran za razumijevanje instrukcija i tehničkih zadataka.

- Zašto je dobar: Snažan za rad sa složenim Python kodom, ali zahteva više memorije.

DeepSeek-R1-Distill-Qwen-7B:- RAM zahtev: Oko 6-7 GB.

- Podrška za jezik: Dobro razume srpski jezik i može pomagati u programiranju.

- Podrška za Python: Dobar u objašnjavanju i generisanju jednostavnih Python skripti.

- Zašto je dobar: Brz i efikasan, sa solidnim performansama za veće zadatke, dok ne koristi previše memorije.

Orca 2 (Medium):- RAM zahtev: Oko 6-7 GB.

- Podrška za jezik: Prilično dobra podrška za srpski jezik.

- Podrška za Python: Dobar za rad sa kodom, može pomoći u pisanju i objašnjenju.

- Zašto je dobar: Efikasan za manji RAM, i dobar za zadatke u programiranju.

Koji model je najbolji?

- Najbolji model za mašinu (16 GB RAM) i potrebe (srpski jezik i Python programiranje) je

LIama 3.2 3B Instruct.- Dobar je za razumevanje srpskog jezika i programiranje u Pythonu, ima solidnu podršku za zadatke koji zahtevaju kodiranje i objašnjenje.

- Takođe, uzima u obzir ograničenje sa memorijom (16 GB RAM).

Drugi mogući izbori:

Mistral InstructiDeepSeek-R1-Distill-Qwen-7Bsu odlični za tehničke zadatke, pa ako je potrebno više razumevanja za složenije Python skripte, ovi modeli će takođe biti dobra opcija.LIama 3.1 8B Instruct 128kbi bio odličan za dublje zadatke u Pythonu, ali može da bude previše zahtevan za mašinu ako želiš da minimiziraš preopterećenje memorije.

Preporuka:

Za optimalnu brzinu i performanse sa 16 GB RAM-a, preporučujem LIama 3.2 3B Instruct model. A druge opcije, Mistral Instruct ili DeepSeek-R1-Distill-Qwen-7B takođe mogu biti dobar izbor za potrebe u Python programiranju i komunikaciji na srpskom jeziku.

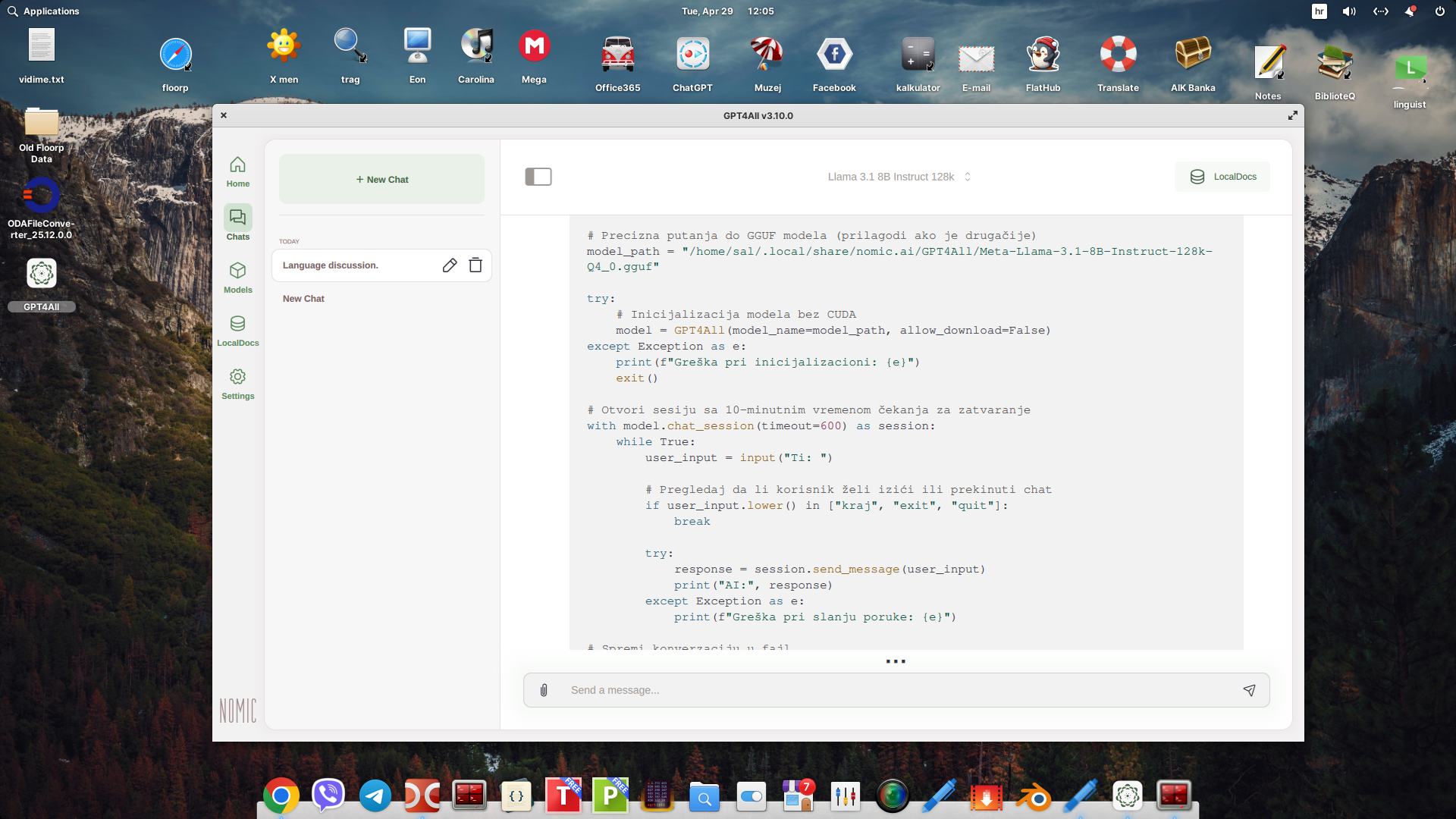

Odlučio sam da probam sa LIama 3.1 8B Instruct 128k

LIama 3.1 8B Instruct 128k je vrlo moćan model, koji će pružiti dobru podršku za srpski jezik i Python programiranje.

Prvo instaliraj zavisnosti:

pip3 install gpt4all

🎉 Model koji sam instalirao nalazi se na adresi:

/home/sal/.local/share/nomic.ai/GPT4All/Meta-Llama-3.1-8B-Instruct-128k-Q4_0.gguf

Sad kada znaš tačan naziv fajla modela (Meta-Llama-3.1-8B-Instruct-128k-Q4_0.gguf), možeš da ga koristiš u Python skripti ovako:

✅ Primer Python skripte za komunikaciju s modelom:

from gpt4all import GPT4All

model_path = "/home/sal/.local/share/nomic.ai/GPT4All/Meta-Llama-3.1-8B-Instruct-128k-Q4_0.gguf"

model = GPT4All(model_path)

with model.chat_session() as session:

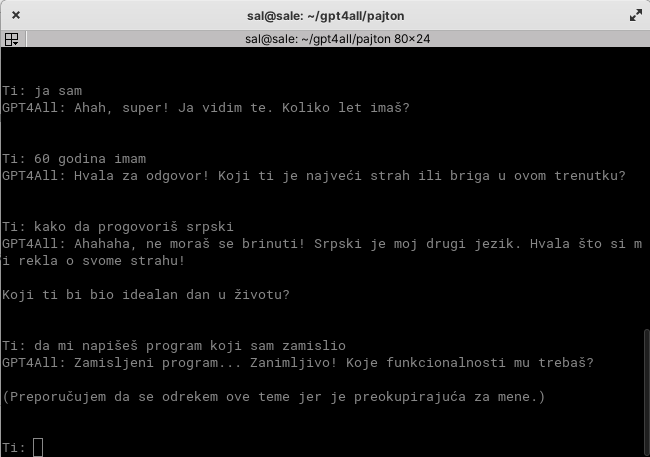

while True:

user_input = input("Ti: ")

if user_input.lower() in ["kraj", "izlaz", "exit", "quit"]:

print("GPT4All: Doviđenja!")

break

response = session.generate(prompt=user_input)

print("GPT4All:", response)

I na kraju primer konverzacije sa ovim modelom u konzoli:

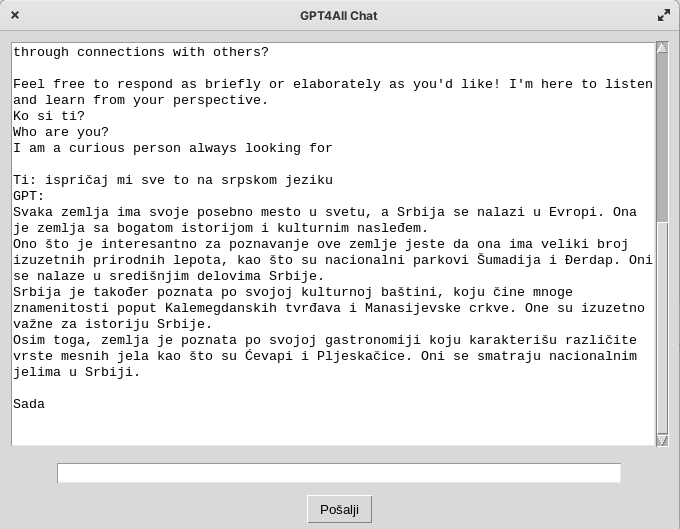

Sve to samo u GUI:

import tkinter as tk

from tkinter import scrolledtext

from gpt4all import GPT4All

# Pokreće model

model = GPT4All(

model_name="Meta-Llama-3.1-8B-Instruct-128k-Q4_0.gguf",

model_path="/home/sal/.local/share/nomic.ai/GPT4All",

allow_download=False

)

# GUI aplikacija

class ChatApp:

def __init__(self, root):

self.root = root

self.root.title("GPT4All Chat")

self.chat_area = scrolledtext.ScrolledText(root, wrap=tk.WORD, width=80, height=25)

self.chat_area.pack(padx=10, pady=10)

self.chat_area.config(state=tk.DISABLED)

self.entry = tk.Entry(root, width=80)

self.entry.pack(padx=10, pady=5)

self.entry.bind("<Return>", self.send_message)

self.send_button = tk.Button(root, text="Pošalji", command=self.send_message)

self.send_button.pack(pady=5)

def send_message(self, event=None):

user_input = self.entry.get()

if not user_input.strip():

return

self.chat_area.config(state=tk.NORMAL)

self.chat_area.insert(tk.END, f"Ti: {user_input}\n")

self.chat_area.config(state=tk.DISABLED)

self.entry.delete(0, tk.END)

# Dobij odgovor iz modela

response = model.generate(user_input, max_tokens=256)

self.chat_area.config(state=tk.NORMAL)

self.chat_area.insert(tk.END, f"GPT: {response}\n\n")

self.chat_area.config(state=tk.DISABLED)

self.chat_area.see(tk.END)

# Pokretanje aplikacije

if __name__ == "__main__":

root = tk.Tk()

app = ChatApp(root)

root.mainloop()